文章来源:潮游速递网作者:admin发布时间:2026-02-15 21:45:13

人工智能的发展势头迅猛,正悄然改变着开发者的创作模式。代码的迭代流转速度日益加快,源源不断地汇入GitHub之类的代码库中,如今机器智能已能与人类展开协同合作。

根据艾伦人工智能研究所的观点,编码代理面临一个核心问题:多数为封闭性质,训练耗费高,且难以对其展开研究或适配私有代码库。为这一难题,该公司今日推出了Ai2开放编码代理,这是一套能让构建与训练自定义编码代理变得简便易行的工具。

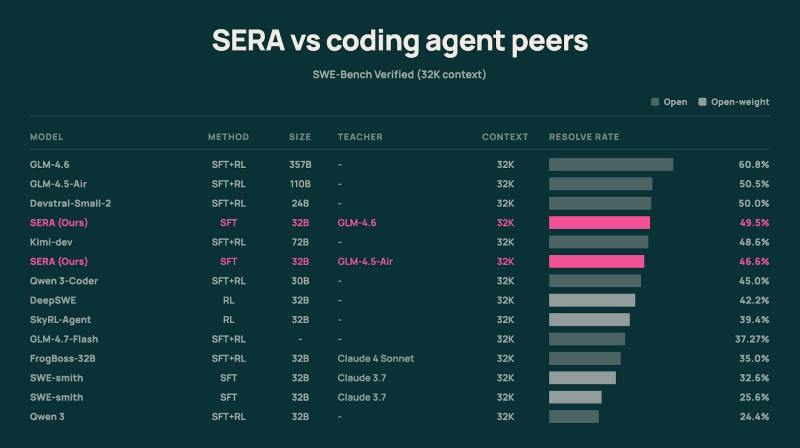

该系列首次推出的版本名为SERA,全称是软验证高效代码库代理,它可以解决SWE-Bench验证问题中超过55%的任务,这一基准表现优于此前同等规模的开源模型。

SERA的各个组件均为开放性质,涵盖模型、代码以及与Anthropic PBC的Claude Code的集成部分。此外,它仅需一行代码即可启动运行。用户无需具备任何大型语言模型的训练经验。

在内部,SERA包含两个版本,分别是SERA-32B与SERA-8B。其中,SERA-32B是参数规模达320亿的模型,具备出色的SWE-bench验证性能表现:在标准配置下,它能解决约55%的相关问题,不仅优于Qwen3-Coder等多数开源模型,也超过了Mistral3的Devstral Small 2这类封闭模型。而SERA-8B作为拥有80亿参数的模型,在匹配的推理环境中,解决了29.4%的SWE-Bench验证问题,相比之下,强化学习基线的解决率仅为9.4%;以具体模型为例,采用Qwen 3 8B模型的SkyRL-Agent-8B-v0解决率为9.4%,SERA-8B则取得了更高的分数。

Ai2采用专门的模型,为每个代码库训练了8000条合成轨迹,其性能不仅持续与GLM-4.5-Air相当,还常常超越后者——而GLM-4.5-Air是一款参数规模超千亿、被用作教师模型的产品。

Ai2指出,一个尤其值得期待的成果是,规模更小的全开放模型能够复刻乃至超越更强大的“教师”编码代理的表现。凭借在特定代码库上实现的优势专业化,以及在320亿参数量级上的微调优化,SERA虽体积仅为部分千亿级通用模型的三分之一,却能在性能上超越它们。这在部署层面意味着更小的内存占用与更低的计算成本,从而在不损失质量的前提下显著降低了开销。

Ai2在普通云硬件上重现主要结果的总成本约为400美元,比市场上许多现有方法便宜约100倍。

公司方面解释道,此次发布涵盖了开发者与研究人员所需的全部内容,旨在帮助他们快速着手进行SERA的重现、测试与构建工作。具体包含基于两行代码的轻量级部署方案,可用于启动、部署和推理操作;此外还有配套的设置脚本以及推理优化机制,能让SERA与Claude Code协同运行。

Ai2方面表示,他们计划采用相同的方法来持续改进技术,并将其扩展至更大型的骨干网络。不过他们也强调,目前的流程已经具备成本低廉且易于实施的特点,任何人都能够对其进行运行、定制以及迭代优化。

需求持续爆发式增长!丰田大举加码混动技术:2028年全球产量目标锁定670万辆

00:32李想表示:全新理想L9不只是一款优质汽车,更是具身智能机器人领域的开创性作品

00:3230万级家用SUV中的佼佼者全新问界M7累计交付量已超10万台

00:31保罗·达诺就被昆汀怒斥一事作出回应:我无需亲自出面回应

00:31《Word》手动双面打印设置教程

00:31“最佳前任”实锤!大疆新春礼盒覆盖全员,离职员工也能收到

00:31别小看午睡的作用!研究表明,午睡习惯正在悄然拉大人们大脑年龄的差距

22:54秋后算账!因技术失误“白送”的《古墓丽影:暗影》启动回收,退款金额为0元

22:50当年走红网络的小胖早已结婚生子,现在和普通大众没什么两样

22:36